Искусственный интеллект (ИИ) стремительно меняет наш мир, открывая беспрецедентные возможности в различных сферах жизни. От здравоохранения и образования до транспорта и развлечений, ИИ проникает во все уголки нашего общества, обещая революционные изменения. Однако, наряду с огромным потенциалом, развитие и внедрение ИИ ставят перед нами серьезные этические вопросы, требующие глубокого осмысления и взвешенного подхода.

Стремительное развитие технологий ИИ, о чем свидетельствует активное обсуждение этических аспектов на площадках, подобных «AI Journey», и создание специализированных организаций, таких как «Альянс в сфере искусственного интеллекта», подчеркивает актуальность этической проблематики в данной сфере. Вопросы предвзятости алгоритмов, обеспечения прозрачности и подотчетности систем ИИ, а также потенциального влияния на рынок труда все это требует тщательного анализа и выработки этических принципов, которые послужат основой для ответственного развития и использования ИИ.

В данном контексте, изучение этических аспектов ИИ приобретает особую важность. Нам предстоит найти баланс между использованием преимуществ ИИ и предотвращением потенциальных рисков, связанных с его применением. Это сложная задача, требующая комплексного подхода с участием представителей различных областей от разработчиков и исследователей до философов, юристов и политиков. Только совместными усилиями мы сможем обеспечить этичное и безопасное будущее в эпоху искусственного интеллекта.

Влияние искусственного интеллекта на общество

Искусственный интеллект (ИИ), некогда футуристическая концепция, стремительно вплетается в саму ткань нашего общества, оказывая глубокое воздействие на все аспекты нашей жизни. Эта трансформация, несущая в себе огромный потенциал для прогресса, одновременно ставит перед нами ряд сложных этических дилемм, требующих пристального внимания и взвешенных решений.

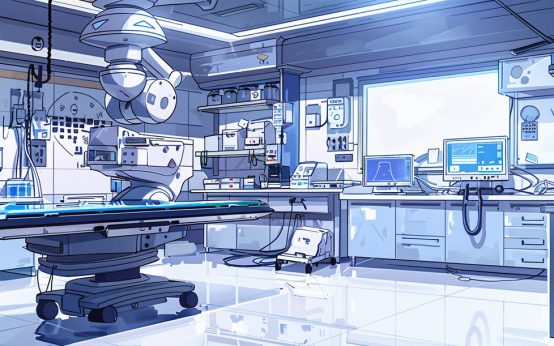

В сфере здравоохранения ИИ открывает беспрецедентные возможности для диагностики заболеваний, разработки новых методов лечения и персонализированной медицины. Алгоритмы машинного обучения способны анализировать огромные объемы медицинских данных, выявляя скрытые закономерности и помогая врачам принимать более точные решения. Однако, наряду с этим, возникают вопросы о конфиденциальности медицинских данных, риске неверных диагнозов, основанных на алгоритмах, и потенциальном влиянии ИИ на взаимоотношения между врачом и пациентом.

В сфере образования ИИ меняет подходы к обучению, предоставляя персонализированные образовательные траектории и автоматизируя рутинные задачи. Интеллектуальные системы обучения способны адаптироваться к индивидуальным потребностям каждого ученика, предоставляя персонализированную обратную связь и поддержку. Однако, внедрение ИИ в образование вызывает опасения по поводу потенциального сужения роли учителя, усиления цифрового неравенства и формирования предвзятости в алгоритмах, используемых для оценки знаний.

В сфере занятости ИИ ведет к автоматизации многих профессий, что вызывает опасения по поводу массовой безработицы и усиления социального неравенства. В то же время, ИИ создает новые рабочие места, требующие навыков работы с данными, программирования и анализа. Это ставит перед нами задачу адаптации системы образования к новым реалиям рынка труда, а также поиска решений для социальной защиты людей, чьи профессии подвержены автоматизации.

Влияние ИИ на общество многогранно и неоднозначно. Необходимо тщательно анализировать как потенциальные выгоды, так и риски, связанные с его применением, чтобы обеспечить этичное и безопасное развитие технологий ИИ на благо всего человечества.

Ответственное использование искусственного интеллекта

В условиях стремительного развития и повсеместного внедрения искусственного интеллекта (ИИ) вопрос его ответственного использования приобретает первостепенное значение. Речь идет не просто о технологическом прогрессе, но и о формировании этических основ, которые определят наше будущее в мире, где ИИ играет все более значимую роль.

Ответственное использование ИИ подразумевает комплексный подход, охватывающий все этапы его жизненного цикла: от разработки и обучения алгоритмов до внедрения и использования систем ИИ. Ключевым элементом этого подхода является принцип «human-centered AI», ориентированный на человека. Это означает, что ИИ должен служить благополучию человека и общества в целом, уважая права и свободы личности.

Важнейшим аспектом ответственного использования ИИ является прозрачность. Алгоритмы и данные, используемые для обучения ИИ, должны быть доступны для анализа и оценки на предмет потенциальной предвзятости и дискриминации. Необходимо создавать механизмы контроля и аудита систем ИИ, чтобы обеспечить их справедливость, объективность и соответствие этическим нормам.

Особое внимание следует уделять вопросам ответственности за решения, принятые с помощью ИИ. Необходимо определить, кто несет ответственность за возможные негативные последствия использования ИИ, и разработать механизмы возмещения ущерба. В этой связи актуальной становится разработка правовых норм и стандартов, регулирующих использование ИИ в различных сферах.

Ответственное использование ИИ – это непрерывный процесс, требующий сотрудничества ученых, разработчиков, представителей бизнеса, государства и общества в целом. Только совместными усилиями мы сможем гарантировать, что ИИ будет служить на благо человечества, а не представлять угрозу его будущему.

Предвзятость и дискриминация в алгоритмах

Внедрение искусственного интеллекта (ИИ) во все сферы жизни общества обнажает критически важную этическую проблему — предвзятость и дискриминацию, заложенные в алгоритмах. Несмотря на кажущуюся объективность, системы ИИ строятся на основе огромных массивов данных, которые, к сожалению, часто отражают существующие в обществе предубеждения и неравенство.

Предвзятость в алгоритмах может проявляться в самых разных формах. Например, системы распознавания лиц, обученные на данных с преобладанием лиц определенной расы, могут демонстрировать низкую точность при распознавании лиц других рас. Аналогично, алгоритмы, используемые в банковской сфере для оценки кредитоспособности, могут дискриминировать заемщиков по признаку пола, возраста, места проживания, основываясь на статистических закономерностях, отражающих исторически сложившееся социальное неравенство.

Проблема усугубляется тем, что алгоритмы часто непрозрачны, и их работа трудно поддается интерпретации даже для специалистов. Это затрудняет выявление и устранение предвзятости, а также делает системы ИИ уязвимыми для злоупотреблений. Например, алгоритмы, используемые в правоохранительной деятельности для прогнозирования преступности, могут приводить к непропорционально частым проверкам в районах с преобладанием этнических меньшинств, усиливая существующую дискриминацию.

Решение проблемы предвзятости и дискриминации в алгоритмах требует комплексного подхода, включающего:

- Разработку этических принципов и стандартов для создания и использования систем ИИ.

- Повышение прозрачности и понятности алгоритмов для обеспечения возможности их контроля и аудита.

- Создание диверсифицированных наборов данных для обучения ИИ, свободных от предвзятости и дискриминации.

- Разработку механизмов обжалования решений, принятых с помощью ИИ, и возмещения ущерба в случае нарушения прав человека.

Только при условии ответственного и этичного подхода к разработке и внедрению ИИ мы сможем избежать усиления существующего неравенства и дискриминации и создать более справедливое и инклюзивное общество.

Прозрачность и подотчетность в системах искусственного интеллекта

Внедрение искусственного интеллекта (ИИ) в различные сферы жизни ставит перед обществом ряд этических вызовов, среди которых особое место занимают прозрачность и подотчетность систем ИИ. Эти два принципа являются краеугольными камнями ответственного использования ИИ, направленного на обеспечение доверия, справедливости и предотвращение возможных злоупотреблений.

Прозрачность в контексте ИИ подразумевает открытость и понятность того, как работают алгоритмы, как они принимают решения и на основе каких данных. Это касается как самих алгоритмов, так и процессов их обучения и тестирования. Необходимо стремиться к тому, чтобы системы ИИ не были «черными ящиками», а их работа была понятна не только разработчикам, но и специалистам в соответствующих областях, а также широкой общественности.

Подотчетность в системах ИИ означает наличие четких механизмов контроля, аудита и оценки их работы, а также определение ответственных лиц за возможные негативные последствия их использования. Важно установить, кто несет ответственность за решения, принятые с помощью ИИ, и каким образом пострадавшие стороны могут обжаловать эти решения и добиться возмещения ущерба.

Достижение прозрачности и подотчетности в системах ИИ — сложная задача, требующая сотрудничества многих сторон: разработчиков, исследователей, государственных органов, бизнеса и общественных организаций. Необходимо разрабатывать новые методы интерпретации и визуализации работы алгоритмов, создавать стандарты документирования и тестирования систем ИИ, а также формировать правовую базу, регулирующую вопросы ответственности за их использование.

Обеспечение прозрачности и подотчетности в системах ИИ — необходимое условие для того, чтобы эти технологии служили на благо общества, способствовали прогрессу и не создавали новых угроз для прав и свобод человека.

Безопасность и риски, связанные с искусственным интеллектом

Развитие искусственного интеллекта (ИИ) открывает перед человечеством невиданные перспективы, но одновременно ставит перед нами и серьезные вызовы, связанные с обеспечением безопасности и минимизацией потенциальных рисков. По мере того, как ИИ все глубже проникает в нашу жизнь, управляя критически важными системами в таких областях, как транспорт, здравоохранение, энергетика, финансы, вопросы безопасности и этические аспекты его применения приобретают первостепенное значение.

Один из основных рисков связан с непреднамеренными последствиями работы алгоритмов ИИ. Обучаясь на огромных массивах данных, системы ИИ могут принимать решения, которые кажутся нам нелогичными, необъяснимыми или даже опасными, поскольку мы не всегда можем полностью контролировать процесс их обучения и интерпретировать принципы их работы. Это может приводить к сбоям в работе систем, непредвиденным последствиям для окружающей среды, а в некоторых случаях и к угрозе жизни и здоровью людей.

Еще одним серьезным риском является возможность злонамеренного использования ИИ. В руках злоумышленников ИИ может стать мощным инструментом для совершения кибератак, распространения дезинформации, манипулирования общественным мнением, нарушения приватности и создания автономных оружий систем, способных наносить ущерб без участия человека.

Для минимизации рисков, связанных с ИИ, необходимо:

- Разрабатывать надежные и безопасные алгоритмы ИИ, устойчивые к ошибкам, сбоям и внешним воздействиям.

- Внедрять эффективные механизмы контроля и верификации систем ИИ на всех этапах их жизненного цикла.

- Создавать правовые и этические нормы, регулирующие разработку, внедрение и использование ИИ, а также ответственность за возможный ущерб.

- Формировать общественное сознание и культуру ответственного использования ИИ.

Обеспечение безопасности и минимизация рисков, связанных с ИИ, — это непрерывная работа, требующая объединения усилий международного сообщества, правительств, научного сообщества, бизнеса и всего общества в целом. Только совместными усилиями мы сможем гарантировать, что ИИ будет служить на благо человечества.

Влияние на рынок труда и рабочие места

Быстрое развитие и повсеместное внедрение технологий искусственного интеллекта (ИИ) оказывает противоречивое влияние на рынок труда и структуру рабочих мест, ставя перед нами ряд сложных этических дилемм. С одной стороны, ИИ автоматизирует рутинные операции, повышает производительность труда и создает новые рабочие места в сфере разработки, внедрения и обслуживания интеллектуальных систем. С другой стороны, автоматизация приводит к сокращению рабочих мест в ряде отраслей, требуя от общества поиска решений для адаптации к новым реалиям рынка труда.

Особенно остро проблема автоматизации затрагивает профессии, связанные с выполнением однообразных, алгоритмизируемых задач. Это касается как физического труда (например, на конвейерных производствах), так и интеллектуального (например, обработка документов, анализ больших объемов данных). В то же время, ИИ создает спрос на специалистов, способных разрабатывать, обучать и внедрять интеллектуальные системы, анализировать их работу и обеспечивать их безопасность.

В этих условиях перед обществом встают следующие этические задачи:

- Обеспечение справедливого перехода к новой структуре рынка труда, минимизация негативных социальных последствий автоматизации.

- Разработка программ переквалификации и повышения квалификации работников, чьи профессии подвержены риску автоматизации.

- Создание новых рабочих мест в сфере ИИ и смежных областях, стимулирование развития инновационной экономики.

- Переосмысление роли образования в условиях быстро меняющегося рынка труда, фокусировка на развитии универсальных навыков (критическое мышление, креативность, коммуникативные навыки), которые сложно поддаются автоматизации.

Влияние ИИ на рынок труда — это не просто экономический, но и социальный и этический вызов. От того, насколько ответственно и гуманно мы подойдем к решению этих проблем, зависит будущее нашего общества.

Этические аспекты автономных систем

Развитие искусственного интеллекта (ИИ) неуклонно приближает нас к эпохе автономных систем – машин, способных действовать в реальном мире без прямого контроля со стороны человека. Беспилотные автомобили, дроны-курьеры, роботы-хирурги – эти технологии уже не фантастика, а стремительно развивающаяся реальность. Однако, наряду с очевидными преимуществами, автономные системы ставят перед нами ряд сложных этических дилемм, требующих глубокого осмысления и выработки новых подходов к их регулированию.

Одним из ключевых вопросов является проблема ответственности за действия автономных систем. Если робот-хирург допускает фатальную ошибку во время операции, кто будет нести за это ответственность – разработчик, производитель, владелец или сам робот? Как определить степень вины каждого из них и обеспечить справедливое расследование инцидентов? Эти вопросы требуют пересмотра существующих правовых норм и разработки новых механизмов регулирования.

Еще одна важная проблема – сохранение контроля над автономными системами. Как гарантировать, что они всегда будут действовать в соответствии с заданными программами и этическими принципами, не представляя угрозы для человека и общества? Как предотвратить возможность их использования в злонамеренных целях или попадания под контроль злоумышленников?

Кроме того, возникают вопросы, связанные с влиянием автономных систем на социальную сферу. Как изменится рынок труда с появлением роботов, способных выполнять многие виды работ, традиционно выполняемых людьми? Как обеспечить социальную справедливость и достойный уровень жизни для всех членов общества в условиях растущей автоматизации?

Этические аспекты автономных систем требуют широкого общественного диалога с участием ученых, инженеров, философов, юристов, политиков и представителей широкой общественности. Только совместными усилиями мы сможем обеспечить, чтобы развитие ИИ и автономных систем служило на благо человечества, а не представляло угрозу его будущему.

Регулирование и этические рамки для искусственного интеллекта

Стремительное развитие и повсеместное внедрение искусственного интеллекта (ИИ) ставят перед мировым сообществом задачу создания эффективной системы регулирования и этических рамок, которые обеспечат ответственное и безопасное использование этих мощных технологий. Необходимость такого регулирования обусловлена тем, что ИИ способен оказывать значительное влияние на все сферы жизни общества, а также нести в себе потенциальные риски, связанные с нарушением прав человека, усилением социального неравенства и даже угрозой существованию человечества.

Создание эффективной системы регулирования ИИ — чрезвычайно сложная задача, требующая междисциплинарного подхода с участием экспертов в области информационных технологий, права, этики, социологии, политологии и других областей знаний. Важно учитывать как потенциальные выгоды, так и возможные риски, связанные с ИИ, а также стремительное развитие этих технологий.

Среди ключевых направлений регулирования и этических рамок для ИИ можно выделить:

- Разработка общих этических принципов для создания и использования ИИ, основанных на уважении прав человека, справедливости, прозрачности и подотчетности.

- Создание международных стандартов безопасности и надежности систем ИИ, а также механизмов сертификации и контроля за их соблюдением.

- Разработка правовых норм, регулирующих вопросы ответственности за действия систем ИИ, защиты персональных данных, предотвращения дискриминации и нарушения других прав человека.

- Стимулирование научных исследований в области этики ИИ и создания инструментов для оценки и минимизации потенциальных рисков.

Регулирование и этические рамки для ИИ должны носить гибкий и адаптивный характер, позволяя учитывать специфику различных отраслей и сфер применения этих технологий. Важно найти баланс между стимулированием инноваций и обеспечением безопасности, а также создать условия для широкого общественного диалога по вопросам развития и применения ИИ.

Роль этики в разработке и применении искусственного интеллекта

В условиях стремительного развития и повсеместного внедрения искусственного интеллекта (ИИ), этика перестает быть абстрактной философской категорией и становится неотъемлемым элементом процесса разработки и применения этих мощных технологий. Именно этика призвана обеспечить, чтобы ИИ служил на благо человечества, способствовал прогрессу и не превратился в инструмент дискриминации, манипуляции или даже угрозы для человека.

Роль этики в контексте ИИ многогранна и проявляется на всех этапах его жизненного цикла:

- На этапе разработки алгоритмов этика должна руководить выбором целей, задач и критериев успешности систем ИИ. Важно гарантировать, что цели и задачи, для которых создается ИИ, соответствуют общечеловеческим ценностям и не противоречат этическим нормам.

- На этапе обучения ИИ необходимо обеспечить использование объективных, репрезентативных и непредвзятых данных, чтобы исключить возможность закладывания в алгоритмы существующих в обществе предубеждений и дискриминационных практик.

- На этапе внедрения и использования ИИ важно обеспечить прозрачность, подотчетность и контролируемость систем ИИ, а также разработать механизмы предотвращения и урегулирования возможных конфликтов и негативных последствий.

Для того чтобы этика стала неотъемлемой частью развития и применения ИИ, необходимо активное участие всех заинтересованных сторон: ученых, разработчиков, бизнеса, государства, общественных организаций и отдельных граждан. Важно вести открытый диалог, разрабатывать этические кодексы и стандарты, а также формировать культуру ответственного отношения к ИИ как среди специалистов, так и среди широкой публики.

Роль машинного обучения в развитии умных городов

Роль машинного обучения в развитии умных городов  Как искусственный интеллект помогает в борьбе с изменением климата

Как искусственный интеллект помогает в борьбе с изменением климата  ИИ и автоматизация: какие профессии исчезнут через 10 лет

ИИ и автоматизация: какие профессии исчезнут через 10 лет  Будущее искусственного интеллекта в медицине

Будущее искусственного интеллекта в медицине  Как ИИ меняет игровые индустрии

Как ИИ меняет игровые индустрии  История искусственного интеллекта: от идей до реальности

История искусственного интеллекта: от идей до реальности